Audio-Postproduktion für Film und Fernsehen

![]() Von Björn Funk

Von Björn Funk

Vorbereitung der Audio-Postproduktion

In den meisten Fällen ist der Tontechniker am Set (O-Tonmeister) nicht derselbe, wie der Tontechniker in der Postproduktion (Mischtonmeister). Und so, wie am Set günstigstenfalls ein Team den Ton aufzeichnet (einer am Mischer, einer an der Angel), so bedeutet Postproduktion meistens Teamarbeit. Filmprojekte werden in Sachen Ton zudem schnell sehr umfangreich. Zumeist kommen 40-50 Spuren zusammen, auch über 100 Spuren sind keine Seltenheit. Da heißt es Überblick bewahren.

Der Quasistandard in der Filmbranche ist Avid Pro Tools, wobei in den letzten Jahren einige Studios (auch ich) auf den Konkurrenten Steinberg Nuendo gesetzt haben. Egal, welches Programm man für die Filmvertonung nutzt: Wichtig ist, dass man es sehr gut beherrscht und sich gut organisiert. Es empfiehlt sich daher, ein Default-Projekt für Filmton anzulegen, in dem man schon für die wichtigsten Tonarten (mindestens O-Ton, Nachsynchron, Effekttöne, Musik) entsprechende Gruppen anlegt und ggf. wichtige Effekte einbindet (dazu später mehr).

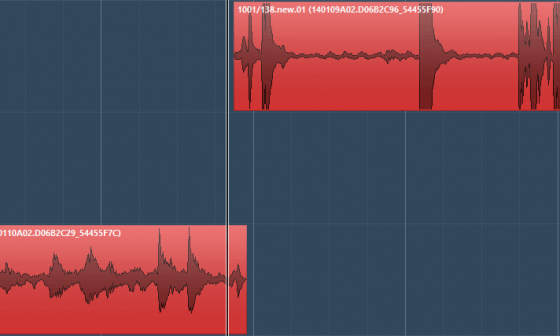

Ich habe mir angewöhnt, den Spuren der einzelnen Gruppen verschiedene Farben zuzuweisen. So fällt es mir leicht, in großen Projekten den Überblick zu bewahren. Eine sinnvolle Benennung der Spuren ist ein weiterer Schritt in die richtige Richtung.

PASSEND DAZU

- Recording am Set: So gelingt dir die Tonaufnahme beim Film

- Tontechnik bei TV-Übertragungen: Interview mit Felix Krückels zur WM2014

- Steinberg Nuage: Mischkonsole für Nuendo

- Podcast #144: Ausbildung zum Toningenieur, Tonmeister oder Tontechniker?

- Professionelle Musikproduktion: „Pro“-Sound (Teil 1)

Die Übergabe – .aaf und .omf

Die Filme werden in einem Videoschnittprogramm (in der Regel Avid Media Composer, Adobe Premiere oder Final Cut) geschnitten. Diese Programme haben gemeinsam, dass sie vor allem auf die Bearbeitung des Bildes ausgerichtet sind. Wenn Du Projekte von einem Cutter (der Mensch, der die Filme schneidet) übernimmst, sollten im Vorfeld einige Dinge mit diesem besprochen werden.

Beispielsweise bietet es sich an, dass alle einer Szene zugehörigen Audiodaten an diese anlegt. Der Ton sollte aber nicht weiter bearbeitet werden. Denn die Entscheidung, welche Tonspur(en) später Verwendung findet, solltest Du treffen. Tipp: Am besten machst Du dem Cutter deutlich, dass er hier Zeit und Arbeit sparen kann, indem er sie auf dich abwälzt.

Für eine einfache Weiterbearbeitung empfiehlt sich die Übergabe des Projekts als .aaf- oder .omf-Datei. Am Besten wird hier mit dem „embedded“-Format gearbeitet. Das bedeutet, dass Du eine große Datei bekommst, in der alle verwendeten Audiodateien enthalten sind. Wird nicht „embedded“ (eingebettet), so verweist die .aaf- bzw. .omf-Datei nur auf den Speicherort der Audiodateien – hierbei könnten Soundfiles vergessen werden.

Bitte unbedingt darum, dass Du die Audiodateien mit einer sogenannten „handle length“ von mindestens 2, besser 5 Sekunden bekommst. Das bedeutet, dass Du in Deiner DAW die einzelnen Clips noch an den vom Cutter gesetzten Schnitten nach vorne und hinten aufziehen kannst. Das wird im weiteren Prozess dringend benötigt.

Übergabe – das Videoformat

Über den Ton hinaus brauchst Du natürlich noch ein Bild, hier sollte ein Videoformat mit Einzelbildern vorliegen. Zwar sind die Videos dann deutlich größer als mit Kompressionsverfahren wie .mpeg – aber zum einen wird dadurch der Prozessor des Rechners entlastet, zum anderen ist es wichtig das Video auf den Frame genau anfahren zu können. Erst dann lassen sich Geräusche und ggf. Sprechertakes bildgenau platzieren.

Timecode

Der so genannte Timecode dient dazu, das Bild und den Ton synchron zu halten. Er setzt sich aus Stunde (hh), Minute (mm), Sekunde (ss) und Einzelbilder/Frames (ff) zusammen. Das sieht wie folgt aus hh:mm:ss:ff. Die Anzahl der Frames hängt vom Quellmaterial ab: Europäisches Fernsehen wird mit 25 Frames pro Sekunde (fps) produziert, im Kino sind 24fps und in den USA knapp 30fps Standard.

Im Bild sollte der Timecode eingestempelt sein, damit eine Synchronisierung von Bild und Ton garantiert werden kann. Außerdem sollte in dem Video der Ton exportiert sein, den der Cutter gemeinsam mit dem Regisseur angelegt hat. Dieser Ton dient dir in der weiteren Produktion als Guide (Leitfaden). Bestenfalls wird hier auf einem Kanal (links) der O-Ton und auf dem anderen Kanal (rechts) die Layoutmusik, die dem Filmkomponisten als Stilvorgabe dient, ausgespielt.

Wenn möglich solltest Du mit dem Regisseur ein Gespräch darüber führen, wie er sich den Filmton vorstellt. Am liebsten schaue ich mir den Film mit dem Regisseur Stück für Stück an, bespreche die einzelnen Szenen und versehe sie mir in meinem Projekt mit Markern. Das erspart, während der Arbeit immer auf irgendwelche Notizen schauen zu müssen.

Hands On

Den Film und die .aaf- bzw. .omf-Datei importierst Du in deine DAW-Software, achte hierbei auf den Timecode. Die korrekte Framezahl kann deine Musiksoftware aus dem Video auslesen, es bietet jedoch an, dies mit dem Cutter abzuklären. Hinweis: Professionelle Sendebänder beginnen nicht mit einem Timecode von 0, sondern bei 09:58:00:00, wobei das eigentliche Sendebild bei 10:00:00:00 startet.

Es empfiehlt sich, dies in der DAW zu übernehmen, damit der Timecode in der Transportbar sowie der in das Video eingestempelte einander entsprechen. Den O-Ton kopierst Du einmal in eine Spur deiner DAW und schaltest ihn stumm bzw. deaktivierst die Spuren. Er dient künftig nur als Backup, falls Du noch einmal an das Original eines Clips musst, der zu stark bearbeitet wurde.

EBU R.128

Bevor Du einen Film abmischst, gilt zu klären, für welches Zielmedium der Film gedacht ist. Soll der Film beispielsweise auf YouTube oder einer vergleichbaren Plattform online laufen, darf er ähnlich wie bei Musik möglichst laut sein. Ist hingegen das Fernsehen Zielmedium, gilt es, sich an der Norm der Senders zu orientieren. Die genauen technischen Spezifikationen erfährst Du vom Sender.

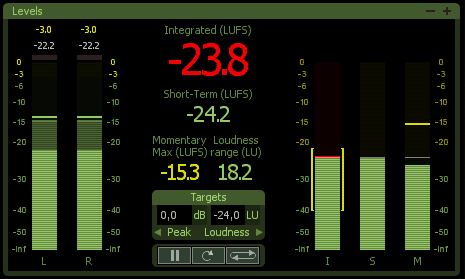

Grundsätzlich gelten in Europa die Spezifikationen der European Broadcasting Union, kurz EBU – für den Ton ist es EBU R 128. Zuvor (und im Radio bis heute) galt die EBU R 68. Bei dieser Norm war lediglich der Spitzenpegel definiert – und zwar mit -9 db FS. Das sind 9 dB unter dem digitalen Maximalpegel, der so genannte Headroom.

Gerade im Radio und im Bereich der Werbung war es üblich, die Gesamtmischung hart gegen einen Limiter zu fahren, womit die Dynamik massiv beschränkt wurde, während die empfundene Lautstärke (technisch korrekt: die Lautheit) anstieg. Dies führte genau zu dem bekannten Effekt, dass die Werbung immer wesentlich lauter klang als das sonstige Programm. Um dies zu ändern, einigte man sich bei der EBU darauf, künftig nicht mehr allein den Spitzenpegel zu definieren, sondern den Durchschnittspegel als Maß zu nehmen.

Dieser wird kompliziert errechnet und in Loudness Units (LU) angezeigt. Eine LU entspricht einem dB, allerdings nicht als Momentanmessung, sondern als Durchschnittsmessung über die gesamte Länge des Programms. Dabei ist es unwichtig, ob es sich um einen 30-sekündigen Werbespot oder einen 90-minütigen Film handelt.

Neben der Messung über die gesamte Programmdauer („integrated“) werden noch zwei weitere Werte ermittelt: einmal die durchschnittliche Lautstärke über 3 Sekunden („short term“), außerdem die durchschnittliche Lautstärke der letzten 400 Millisekunden („momentary“). Zusätzlich zu der Durchschnittslautstärke, die für das Gesamtprogramm mit -23 LUFS (also 23 dB unter der digitalen Vollaussteuerung, dieser Wert wird auch als 0 LU festgehalten) ist auch der Spitzenpegel definiert.

Laut EBU R128 liegt dieser bei -1 dbFS True Peak – gerade hier weichen einige Sender von den internationalen Vorgaben ab. So gönnen sich ARD und ZDF derzeit 3 dbFStp Headroom.

Über die EBU R128 könnte man viel schreiben, als kurzer Überblick sei es an dieser Stelle genug. Weitere Informationen findest Du hier:

» R128 – Die leise Revolution der Pegelmessung

Mittlerweile bieten die meisten DAWs eine Pegelmessung gemäß der EBU R 128 an, zudem gibt es diverse Metering PlugIns, die diese Messung ebenfalls durchführen. Die von mir genutzte Audio Post DAW Steinberg Nuendo bietet sogar eine eigene Loudnessspur, mit der man den aktuellen Stand seiner Mischung immer gut im Griff hat.

O-Ton Sichtung

Nachdem Du die .aaf- bzw. .omf-Datei und das Video importiert hast, sollte als erstes überprüft werden, ob der O-Ton und die Referenzmischung aus dem Schnitt synchron liegen. Auch im weiteren Produktionsverlauf sollte man immer darauf achten, ob der O-Ton noch lippensynchron ist.

Am Besten kopierst Du den O-Ton einmal in deiner Session und deaktivierst die Spuren mit den Originaldateien. So kannst Du immer schnell auf die ursprüngliche Version zurückgreifen. Nun folgt die O-Ton Sichtung und die O-Ton Säuberung.

Hier gehst Du Clip für Clip vor: Zunächst hörst Du dir die einzelnen Clips des O-Tons an. Wenn der Cutter mehrere Clips angelegt hat (z.B. Anstecker von Schauspieler 1, Anstecker von Schauspieler 2 und Ton von der Angel), entscheidest Du, welche Spur im konkreten Fall genutzt werden soll, oder ob es gar am besten ist, mehrere Spuren zusammen zu mischen. Die O-Ton Spuren werden in einem gemeinsamen Bus zusammengeführt, in welchem einige Effekte (Declicker, Echtzeit-Denoiser De-Esser) aktiviert werden.

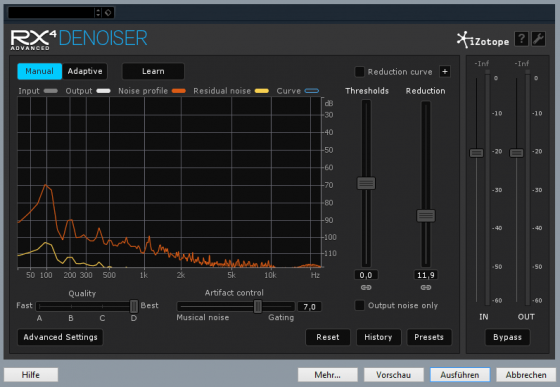

O-Ton Säuberung

Als nächsten Schritt hörst Du dir die Clips einzeln an. Wenn Störgeräusche vorliegen, werden diese gezielt mit einem Denoiser bekämpft. Am besten wird der Effekt direkt in den Clip gebounct. Denoiser sind wahre Leistungsfresser und in einer Filmmischung braucht man jede Ressource.

Oft ist es besser, dass sich ein gewisses Grundrauschen (Noise Floor) konstant durch die ganze Szene zieht, als jegliches Nebengeräusch zu töten. In einigen Fällen lohnt es sich, so genannte Schmutzbrücken zu bauen. Gemeint sind „stille“ Stellen aus einem anderen Teil der Szene. Ein leiser Noise Floor wirkt authentisch und verschmilzt später mit der Atmo, die angelegt wird.

Wenn ein O-Ton trotz aller technischen Maßnahmen nicht brauchbar ist, notiert man sich den entsprechenden Timecode. Diese Szenen müssen zu einem späteren Zeitpunkt von den Schauspielern nachsynchronisiert werden.

Die Clips werden so eingepegelt, dass die Sprache bei einem Short Term Wert von ungefähr -22 LUFS (entsprechend +1 LU) liegt. Dies ist erfahrungsgemäß ein guter Ausgangswert für die Mischung für ein Video oder einen Film. Außerdem ziehst Du den Anfang und das Ende der Clips ein bisschen breiter, so dass zwischen den Clips kurze Crossfades angelegt werden können.

Dies machst Du auch dann, wenn im Bild ein harter Schnitt gesetzt wird. Die kurzen Crossfades sind für das menschliche Ohr angenehmer. Es lohnt sich auch, die Stellen des O-Tons, die später für Effektsounds herangezogen werden sollen, auf eine eigne Spur zu packen. Man spricht hier auch von PFX.

Sound Design für Filmton

Beim Sound Design markiert man sich am besten zunächst die einzelnen Szenen. Dies gilt insbesondere, wenn der Szenen- mit einem Ortswechsel verbunden ist. Das bedeutet zwar viel Arbeit, hilft aber ungemein, wenn später die Atmos angelegt werden. Insgesamt hilft das auch bei der weiteren Orientierung in dem Film und das schnelle Finden der Szenenübergänge im weiteren Produktionsverlauf wiegt den Aufwand bei der Erstellung der Marker allemal auf.

Einige DAW-Programme können gleich mehrere Markerspuren verwalten. Falls Deine DAW dies nicht beherrscht, kannst Du als Ersatz eine Audiospur anlegen und jeweils einen stummen Audioclip in der Länge der Szene anlegen (oder bouncen).

An dieser Stelle sollte man den Film ganz anschauen und jede Stelle markieren, an der ein Geräusch ersetzt oder ergänzt wird. Nun folgt die mühselige Arbeit mit den Samples. Ein Hoch auf jeden Produzenten, der eine gut organisierte Datenbank hat.

Insbesondere die Atmos sind wichtig, denn mit diesen wird die Stimmung einer Szene erheblich beeinflusst – ohne dass der Zuschauer dies bewusst wahrnimmt. Hier bedarf es eines gewissen Gefühls für die Dramaturgie, das freilich beim Setzen der Effektsounds genausowenig schaden kann.

Beispiele: Heutzutage ist es durchaus üblich, dass jedes Auto, das durch das Bild fährt, im Nachhinein vertont wird (und dabei mindestens 30 PS hinzugewinnt, weil es groß und nach Hollywood klingen soll). Gleichzeitig macht es für die Wahrnehmung einen Unterschied, ob eine Tür einfach aufschwingt, oder ob sie dabei quietscht.

Was für den Produzenten mühsam ist, hinterlässt eine deutlicht Prägung auf die Gesamtwirkung eines Films. Ich empfehle, sich dieses Werbevideo einmal mit und ohne Ton anzuschauen. Das verdeutlicht die Wirkung von FX-Sounds mehr als jede theoretische Abhandlung.

Postproduktion: Foley-Aufnahmen

In der Zeit vor den riesigen Sample-Libraries haben Geräuschemacher einen Film alleine vertont, heute ergänzen sie eher das Sounddesign. Weshalb nimmt man überhaupt noch Geräusche auf, anstatt alles aus den Datenbanken zu übernehmen? Ein guter Geräuschemacher ist schneller, als jeder Sounddesigner sein könnte. Er kann in einer Szene die Schritte von zwei Leuten gleichzeitig vertonen – und das (nahezu) bildsynchron. Müsste man jeden einzelnen Schritt als Sample anlegen, würde man ungleich länger brauchen.

Foley-Aufnahmen gehören zu den kreativsten Tätigkeiten in der Audio-Postproduktion. Hier werden die verschiedensten Tricks angewandt, um die anliegenden Bilder zu vertonen. Dabei hat jeder Geräuschemacher seine ganz eigenen Tricks. Es lohnt sich, mal auf Videoplattformen nach „sound design“ oder „foley“ zu suchen, um einige dieser Tricks abzukupfern.

Insbesondere wenn eine internationale Fassung der Mischung gefordert ist, sind Foleysounds unumgänglich. Wenn die Sprachspur gemutet wird, geht eben auch viel an O-Tönen verloren.

ADR / Nachsynchronisieren

Wenn eine Szene im O-Ton unbrauchbar sein sollte, muss sie nachsynchronisiert werden. Im Filmjargon hat sich der Begriff ADR (Advanced Dialoge Recording) eingebürgert. Bestenfalls hast Du dafür ein so genanntes Takersystem zur Hand, wie es manche DAWs serienmäßig oder als Erweiterung anbieten. Zur Not funktioniert es auch ohne.

Zur Vorbereitung sollten die einzelnen Takes der Schauspieler mit Loop Markern gekennzeichnet werden. Das erleichtert das Anspringen der jeweiligen Szene und visualisiert, wie lange die Schauspieler reden können. Im besten Fall sprechen die Schauspieler ihre Texte lippensynchron nach, manchmal muss man da als Tontechniker auch nacheditieren. Auf jeden Fall ist es von Vorteil, wenn der Regisseur des Films oder zumindest ein Dialog-Regisseur bei den Aufnahmen anwesend ist. Dies ist insbesondere dann wichtig, wenn nicht aus technischen Gründen nachsynchronisiert wird: Also wenn Schauspieler ihr Spiel variieren sollen oder die Redaktion Textergänzungen wünscht.

Ist ein Regisseur anwesend, kannst Du Dich auf die technische Seite der Aufnahme konzentrieren und darfst die dramaturgischen Aspekte außer Acht lassen. Anmerkung: In der professionellen Synchronisation sitzt teilweise noch ein Cutter im Aufnahmeraum, dessen wichtigste Aufgabe es ist, auf eine lippensynchrone Performance zu achten.

Von der technischen Seite her ist das Synchronisieren ein wenig tricky. Du musst dafür sorgen, dass sowohl Regisseur als auch Schauspieler das Bild sehen können. Mit zwei Bildschirmen zu arbeiten ist hier Pflicht. Noch besser ist ein dritter Monitor, so dass das Bild sowohl im Aufnahmeraum als auch in der Regie wiedergegeben werden kann.

Die meisten Studios nutzen für ADRs großmembranige Kondensatormikrofone. Es ist immer eine Überlegung wert, ob ein Richtmikrofon oder ein Anstecker (Lavalier-Mikrofon) besser geeignet sind. Zwar klingen diese nicht so „schön“ wie ein Großmembranmikrofon, dafür ist ihr Klang dem Klang der am Set verwandten Mikrofone viel näher – und das bedeutet weniger Arbeit beim Matching des Sounds weniger Arbeit hast.

Score und Source

Hier geht es um die Musik, und damit ist eine Begriffsverwirrung vorprogrammiert. Umgangssprachlich nennt man die Filmmusik gerne „Soundtrack“. Dieser Begriff meint aber im professionellen Umfeld die komplette Filmmischung: also alles inklusive O-Tönen, ADR, FX und Foleys. Daher solltest Du dir gleich angewöhnen, lieber von Score und Source zu sprechen. Unglücklicherweise werden diese Begriffe aber unterschiedlich verwendet….

Wenn es um die Abrechnung geht, unterscheidet man wie folgt: Score ist Musik, die eigens für den Film bzw. die einzelne Szene komponiert wurde. Mit Source meint man in diesem Zusammenhang Musik, die schon vorher existierte und im Film verwendet wurde – also zum Beispiel ein bekannter Popsong. Eine wichtige (wenn auch langweilige) Aufgabe ist es, später in der fertigen Session zu schauen, wie lang die verwendete Musik ist.

Die Abrechnung für die Filmkomponisten erfolgt anhand der Länge der verwendeten Musik und auch bei Popsongs errechnen die Verwertungsgesellschaften (also in Deutschland derzeit die GEMA) ebenfalls die Bezahlung nach der Dauer.

Dramaturgisch spricht man von Score, wenn die Musik aus dem Off kommt und die Szene untermalt. Source nennt man hier Musik, die aus dem Bild heraus erklärbar ist, also wenn etwa eine Band spielt oder eine Stereoanlage zu sehen ist. Du kannst kleine Kniffe nutzen: wenn anfangs die Musik durch eine Stereoanlage erklingt und sie nach vorne mischst, wenn der Hauptdarsteller zu tanzen anfängt. Hier spricht man davon, dass die Source zum Score wird. Spätestens, wenn der Regisseur dies von dir wünscht, solltest Du beide Bedeutungen dieser Begriffe kennen.

Gute Filmmusik zeichnet sich dadurch aus, dass sie Platz für die Sprache und bestenfalls auch für das Sounddesign lässt. Manchmal lohnt es sich, in einer Szene probehalber die Musik zu muten. Es kann sein, dass dadurch das Spiel der Darsteller stärker wird.

Um die Wirkungsweise von Filmmusik zu verstehen, empfehle ich, die Star Wars Filme anzuschauen. Hier hat jeder Hauptcharakter sein eigenes Thema, was ihn durch den Film trägt. Als Kontrast empfiehlt sich „Die Vögel“ von Hitchcock, der seine beklemmende Atmosphäre unter anderem dadurch erhält, dass er komplett auf Filmmusik verzichtet.

Mischung

Nun kommt der große Moment, in dem Du alle Einzelteile zusammenfügst – eine gute Organisation ist das A und O. Am besten routest Du den O-Ton, Voice-Overs und ADR, FX und PFX, Atmos, Source und Score jeweils in eine eigene Gruppe. Um die Übersichtlichkeit zu erhöhen, können die einzelnen Gruppen mit verschiedenen Farben gekennzeichnet werden. Selbst bei einer „kleinen“ Filmmischung kommen schnell 40 – 50 Spuren zusammen.

Auch Effektspuren lohnen sich: Wenn etwa in einem Film viel telefoniert wird, kannst Du dafür eine eigene Spur anlegen und in dessen Insert einen „Telefon-EQ“ packen. Wann immer nun in dem Film jemand durch das Telefon zu hören ist, wird der O-Ton auf die Telefonspur gezogen – Du entgehst so einer sich wiederholenden Automatisierung.

Wenn Du sowohl den O-Ton als auch die weiteren Elemente sauber eingepegelt hast, kannst Du die eigentliche Filmmischung rein über die angelegten Gruppenspuren fahren. Mische den Film erst einmal grob ab. Achte besonders darauf, ADR und Foley-Aufnahmen mit einem Hall zu versehen, der zu der jeweiligen Gesamtszene passt. Achte auch darauf, dass die ADRs möglichst nah an den O-Ton heran kommen – der Zuschauer soll nicht merken, dass hier gemogelt wurde.

Mit der Zeit haben sich einige Standards herausgebildet, an denen Du dich orientieren kannst. Dialoge werden in der Regel in die Stereomitte gemischt, selbst bei 5.1-Mischungen kommen 90% der Dialoge über den Centerlautsprecher. Auch FX-Sounds werden meist nicht hart nach rechts oder links gedreht. Letztlich muss man sich hier immer in Erinnerung rufen, dass der Ton das Bild unterstützen und nicht in Konkurrenz zu ihm treten sollte.

Die finale Mischung sollte am besten gemeinsam mit dem Regisseur gemacht werden. Spätestens hier zahlt es sich aus, wenn Du ein stabiles System hast, welches Du perfekt beherrschst. Und der Überblick, denn Du dir mit den verschiedenfarbigen Spuren verschafft hast, hilft dir, um die Ideen des Regisseurs schnell und zielsicher umzusetzen.

Während der Mischung sollte auch der Pegel im Blick behalten werden. Es lohnt sich, für das Finale des Films noch ein wenig Luft nach oben zu lassen. Wer nach dem EBU R128 abmischt, kann sich an einer größeren Dynamik erfreuen. Für Produktionen, die auf Videoplattformen veröffentlicht werden, sollte der Ton hingegen stärker komprimiert werden. Aber auch hier sollte wenigstens 3 dB Headroom gelassen werden. Die Datenreduktion des Tons sorgt mitunter für ein Ansteigen des Pegels bei der Kompression auf dem Weg zur Videoplattform. Ohne Headroom kommt es gerne zu digitalen Verzerrungen (das gilt im Übrigen auch für Musikproduktionen).

Abnahme

Die Mischung ist erledigt, der Regisseur ist zufrieden. Wenn Du ein Video fürs Web gemacht hast, bist Du an dieser Stelle so gut wie fertig. Ganz anders sieht es aus, wenn Du eine Produktion für das Fernsehen machen solltest. Dann steht dir die größte Feuerprobe noch bevor: die Abnahme.

Meist finden sogar zwei Abnahmen statt: eine inhaltliche und eine technische. In der erstgenannten muss der Film vor den Produzenten des Films sowie den Redakteuren des beauftragenden Senders bestehen. Diese Abnahme kann lang und anstrengend sein, schließlich prallen hier verschiedene künstlerische Vorstellungen aufeinander. Nach der Abnahme kommt der Mixdown. Entweder wird der Film gebounced oder Du lässt ihn in Echtzeit laufen und nimmst die Summe auf einen eigenen (Stereo- bzw- Surround-) Kanal auf. Letzteres ermöglicht dir noch eine letzte Qualitätskontrolle.

Schließlich kommt es von Seiten des Senders noch zu einer technischen Abnahme. Wenn Du geschludert hast, bekommst Du den Film zurück und musst nacharbeiten. Wenn der Sendetermin näher rückt, ist das…unerfreulich.

Delivery

Zu einer professionellen Filmmischung gehört eine so genannte Delivery – ein Dokument, das Du am Anfang ausgehändigt bekommst und die technischen Rahmendaten spezifiziert. Außerdem legt der Auftraggeber hier fest, was Du alles abliefern musst. Neben der eigentlichen Filmmischung (bzw. den Mischungen, so eine Fassung in 5.1 und eine gesonderte Fassung in Stereo gefordert wurde) werden häufig weitere Einzelmischungen eingefordert. Dazu können ein Dialogmix, ein FX-Mix, ein Musikmix sowie die so genannte IT-Fassung gehören. Die ersten drei Mischungen kann man einfach aus den Gruppen, die man angelegt hat, abzweigen.

Die IT-Fassung ist eine Mischung, in der alles bis auf die Dialoge vorhanden ist. Da durch das Muting der Dialoge auch andere Sounds (beispielsweise Schrittgeräusche) verloren gehen, ist hier ein verstärkter Einsatz von Foleysounds von Nöten. Hier wäre also nochmal Handarbeit angesagt.

Außerdem kann es vorkommen, dass aus rechtlichen Gründen einzelne Musikstücke für die internationale Fassung ausgetauscht werden müssen. Dies ist jeweils mit dem Auftraggeber abzuklären.

Die Delivery klärt außerdem ab, in welcher Form die erstellten Daten auszuliefern sind. Heutzutage ist es üblich, die Mischungen auf einem Server zum Download bereitzustellen. Ab und an kann es vorkommen, dass sie zusätzlich auf DVD gebrannt werden sollen. Wenn Du alles ordnungsgemäß abgeliefert hast, kannst Du Dich an den langweiligsten und schönsten Teil der Arbeit machen: die Rechnung schreiben.